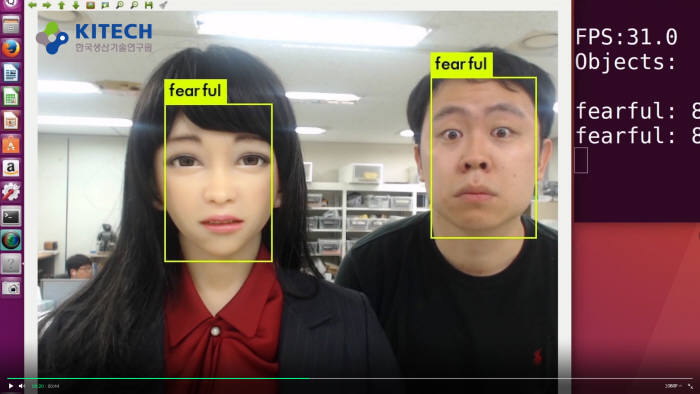

국내 연구진이 딥러닝 기술을 활용해 사람이나 로봇의 얼굴에 떠오르는 다양한 감정 상태를 가려내는 기술을 개발했다. 이 기술을 적용하면 로봇이 정확한 표정을 구현할 수 있게 하는 기준을 객관화해서 제시할 수 있다.

한국생산기술연구원(원장 이성일)은 장인훈 융합생산기술연구소 로봇그룹 박사팀이 사람의 표정 빅데이터를 딥러닝 기술로 학습해서 로봇을 비롯한 피사체의 얼굴 표정, 표현 감정을 판별하는 감정 인식 기술을 개발했다고 10일 밝혔다.

로봇은 최근 생산뿐만 아니라 각종 서비스 및 마케팅 분야로도 적용 분야를 넓히고 있다. 사람의 것과 유사한 표정을 구현하면 친근한 이미지를 구현, 활용도가 더욱 커진다.

문제는 로봇이 짓는 표정과 감정 상태를 객관 평가할 수 있는 기준이 미흡하다는 점이다. 업계는 그동안 여러 명을 대상으로 로봇 표정에 대한 각자의 주관화된 감상을 묻는 방법을 주로 썼다. 정확도가 떨어질 수밖에 없다.

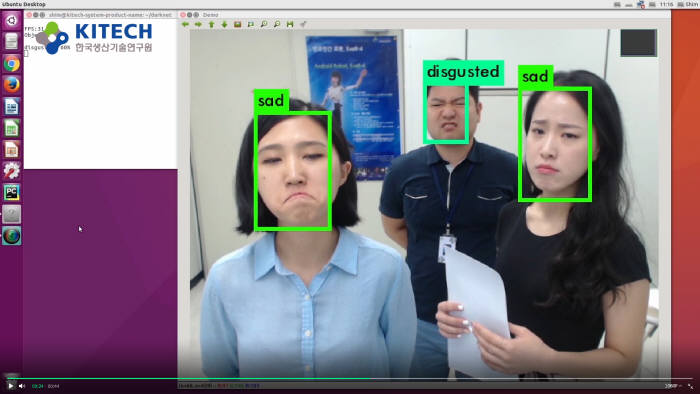

연구팀은 사람의 얼굴 사진 빅데이터와 딥러닝 기술을 활용, 객관 평가 기준을 만들었다. 표정과 감정을 수치화했다. 빅데이터는 네덜란드 라드바우트대 행동과학연구소가 구축한 8040장의 얼굴 사진 데이터베이스(DB) 'RaFd'를 활용했다. 전체 사진의 80%는 학습용으로 사용했다. 나머지 20%는 성능 시험을 위해 썼다. 딥러닝 학습에는 오픈소스 아키텍처인 '요로V2'를 활용했다. 총 4만5000번의 학습으로 판별의 정확도를 높였다. RaFd 사진 기준 판별 정확도가 99.89%에 이른다. 가려낼 수 있는 표정 및 감정은 8가지다. 슬픔, 기쁨, 화남, 놀람 등 1차 감정뿐만 아니라 부끄러움이나 질투 같은 미묘한 감정도 인식한다.

연구팀은 감정인식기가 정면뿐만 아니라 측면이나 대각선에서 본 표정도 정확하게 가려낸다고 설명했다. RaFd는 5개 각도에서 본 얼굴 표정을 담고 있다.

주된 활용처는 생기원이 개발한 로봇 '에버'다. 감정인식기로 에버의 표정과 표현 감정을 수치화하고, 수치 점수가 높아지도록 조정한다. 이미 에버 4에 시험 적용했다. 현재 개발하고 있는 에버5도 감정 인식 기술을 활용, 표정 및 감정 표현 능력을 높일 방침이다. 이 밖에 사람의 감정을 인식해서 치료를 돕는 의료 분야를 비롯해 다양한 산업에 응용할 수 있다.

장인훈 박사는 “그동안 미흡하던 로봇의 표정 및 감정 표현을 더욱 세밀하게 만들 수 있는 기반 기술을 개발했다”면서 “생기원이 만든 에버는 물론 다양한 산업 분야에 적용, 이용자의 만족도를 높일 수 있다”고 말했다.

대전=김영준기자 kyj85@etnews.com