아주대학교는 서형탁 첨단신소재공학과·에너지시스템학과 교수 연구팀이 지능형 머신비전용 뉴로모픽 광감지 메모리 센서를 개발했다고 30일 밝혔다.

단일 칩에서 이미지 감지·분류·이동 예측까지 수행해 처리 속도는 기존 대비 약 200배, 전력 소모는 약 1000배 줄였고, 이벤트성 이미지 판별·분류 정확도 약 93%, 이동 추적·예측 정확도 약 20~80%를 확인했다. 대용량 영상을 외부로 보내던 구조의 병목을 칩 위(온칩)에서 해소해 자율주행·로봇·보안·의료 등 실시간 영상 처리 분야로의 확산 가능성을 높였다.

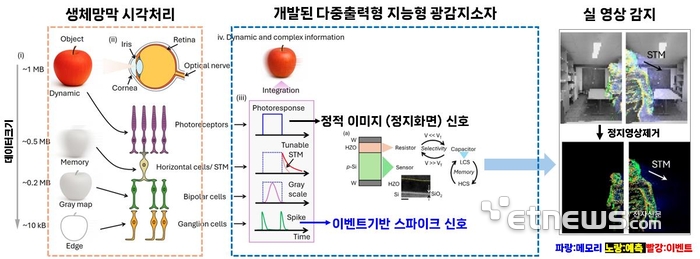

이 소자는 정지(배경) 신호는 정적 광전류로, 밝기 변화에 따른 이벤트(움직임)는 전류 스파이크 기반 단기 메모리(약 0.001초 이내)로 기록해 유의미 픽셀만 선택적으로 처리한다. 생체 망막의 수평세포-신경절세포 회로를 모사해 측면 억제(lateral inhibition)로 경계 대비와 감도를 높이고, 스파이크 신호로 데이터 압축과 노이즈 억제를 동시에 달성했다.

재료·소자 측면에서는 강유전성 헤프늄-지르코늄 복합산화물(HfZrO, HZO)을 실리콘 기판 위에 적층해 전압 제어에 따라 전류·정전용량 등 서로 다른 신호 모드를 선택 출력하는 다중 출력 특성을 구현했다. 이에 따라 정지·이동 구분과 메모리 유지 시간(잊힘 시간) 조절이 가능해 에너지 효율적 연산이 가능해졌고, 실리콘 접합 기반 구조로 기존 반도체 양산 공정과의 호환성도 확보했다.

연구팀은 적응형 학습을 적용해 실제 측정 영상에 대해 실시간 시공간 분류와 모션 예측을 단일 칩에서 입증했다. 카메라-네트워크-중앙처리로 이어지는 전통적 머신 비전의 대역폭 제약·지연 증가·데이터 손실 문제를 센서·메모리·전처리의 칩 내 통합으로 줄인 점에서 시스템 수준의 의미도 크다. 공정 검사, 자율주행, 휴머노이드, 스마트 감시, 수술 보조 등 엣지 환경에서 요구되는 초저전력·저지연 인지 요건에 부합한다는 평가다.

이 연구는 과학기술정보통신부·한국연구재단의 차세대지능형반도체기술개발사업과 중견연구(기초) 지원으로 수행됐으며 특허 출원이 진행 중이다.

서형탁 교수는 “기존 머신비전의 데이터 병목을 해소하기 위해 이벤트 기반 인코딩과 메모리 기반 지능형 프로세스를 단일 칩으로 구현했다”며 “실리콘 접합 소자 구조로 설계해 양산 공정 적용 가능성까지 확보했다”고 말했다.

연구 성과는 나노 분야 국제학술지 'Nano Energy' 9월호 온라인판에 'A neuromorphic photodetector with ferroelectric-controlled static, event, and short-term memory modes for on-chip real-time spatiotemporal classification and motion prediction'라는 제목으로 게재됐다.

수원=김동성 기자 estar@etnews.com